NVIDIA Vera Rubin durchbricht die GPU-Form mit 600-Kilowatt-Racks und Millionen-Token-Speicher

NVIDIA-CEO Jensen Huang ließ auf der GTC 2025 eine Bombe platzen, die die Infrastrukturteams zu ihren Taschenrechnern greifen ließ: Die Vera Rubin-Plattform wird die Racks in Rechenzentren bis 2027 auf 600 Kilowatt bringen.¹ Die Ankündigung markiert einen grundlegenden Wandel in der Funktionsweise von Rechenzentren und zwingt zu einem kompletten Überdenken der Stromversorgung, der Kühlsysteme und der physischen Infrastruktur, die seit Jahrzehnten im Wesentlichen unverändert geblieben ist.

Die Vera Rubin-Plattform ist der bisher ehrgeizigste Schritt von NVIDIA. Dieses Mehrkomponentensystem kombiniert die kundenspezifische Vera CPU, die Rubin-GPU der nächsten Generation und den speziellen Rubin CPX (Context Processing eXtension) Beschleuniger, der speziell für KI-Arbeitslasten mit Millionen von Token entwickelt wurde.² Im Gegensatz zu den inkrementellen Verbesserungen, die für GPU-Generationen typisch sind, liefert die Vera Rubin NVL144 CPX-Variante die 7,5-fache KI-Leistung der aktuellen Blackwell GB300-Systeme und verändert dabei grundlegend die Art und Weise, wie GPUs verpackt, gekühlt und eingesetzt werden.³

"Wir sind das erste Technologieunternehmen in der Geschichte, das vier Generationen von etwas ankündigt", erklärte Huang gegenüber Data Center Dynamics und legte die Roadmap von NVIDIA bis 2028 dar.⁴ Die Transparenz dient einem wichtigen Zweck: Sie verschafft Infrastrukturanbietern, Betreibern von Rechenzentren und Unternehmen wie Introl die nötige Vorlaufzeit, um sich auf eine komplette Neukonzeption der KI-Infrastruktur vorzubereiten.

Die Spezifikationen der NVIDIA Vera Rubin NVL144-Plattform zeigen 3,6 Exaflops FP4-Inferenzleistung und eine 3,3-fache Verbesserung gegenüber dem GB300 NVL72, der in der zweiten Jahreshälfte 2026 auf den Markt kommt.

Die Architekturrevolution beginnt mit kundenspezifischem Silizium.

NVIDIAs komplette Roadmap von Blackwell bis Feynman, die die Entwicklung von Oberon bis zu Kyber-Rack-Architekturen mit bis zu 600 kW Leistungsaufnahme zeigt.

Mit der Vera-CPU wendet sich NVIDIA von ARM-Designs von der Stange ab. Sie verfügt über 88 kundenspezifische ARM-Kerne mit gleichzeitigem Multithreading, was 176 logische Prozessoren ermöglicht.⁵ NVIDIA nennt die benutzerdefinierten Kerne "Olympus", und das Design liefert die doppelte Leistung der Grace-CPU, die in den aktuellen Blackwell-Systemen verwendet wird.⁶ Jede Vera-CPU ist über eine 1,8 TB/s NVLink C2C-Schnittstelle mit den Rubin-GPUs verbunden, was eine noch nie dagewesene Bandbreite zwischen den Rechenelementen ermöglicht.⁷

Die Standard-Rubin-GPU stößt mit 288 GB HBM4-Speicher pro Gehäuse an ihre Grenzen. Damit wird die gleiche Kapazität wie bei der Blackwell Ultra B300 beibehalten, aber die Speicherbandbreite von 8 TB/s auf 13 TB/s erhöht.⁸ Jedes Rubin-Gehäuse enthält zwei GPU-Dies mit Fadenkreuzbegrenzung, wobei NVIDIA seine Zählmethode geändert hat - was bei Blackwell eine GPU (zwei Dies) war, sind bei Rubin zwei GPUs.⁹ Diese Änderung spiegelt die zunehmende Komplexität von Multi-Die-Architekturen wider und hilft Kunden, die tatsächlichen Rechenressourcen in jedem System besser zu verstehen.

Das innovativste Element ist der Rubin CPX, ein speziell entwickelter Beschleuniger für die Verarbeitung massiver Kontexte. Das monolithische Design liefert 30 petaFLOPs NVFP4-Rechenleistung mit 128 GB kosteneffizientem GDDR7-Speicher, der speziell für Aufmerksamkeitsmechanismen in Transformer-Modellen optimiert ist.¹⁰ Der CPX erreicht eine dreifach schnellere Aufmerksamkeitsleistung im Vergleich zu GB300 NVL72-Systemen und ermöglicht KI-Modellen die Verarbeitung von Kontexten mit Millionen von Token - was einer Stunde Video oder ganzen Codebases entspricht - ohne Leistungseinbußen.¹¹

Die Bereitstellung erfordert eine vollständige Überarbeitung der Infrastruktur.

Das standardmäßige Vera Rubin NVL144-System, das in der zweiten Jahreshälfte 2026 auf den Markt kommen soll, ist mit der bestehenden GB200/GB300-Infrastruktur kompatibel und nutzt die bekannte Oberon-Rack-Architektur.¹² Das System verfügt über 144 GPU-Dies (72 Pakete), 36 Vera-CPUs und liefert 3,6 exaFLOPS FP4-Inferenzleistung - eine 3,3-fache Verbesserung gegenüber Blackwell Ultra.¹³ Der Stromverbrauch bleibt mit etwa 120-130 kW pro Rack überschaubar, ähnlich wie bei aktuellen Implementierungen.

Die Vera Rubin NVL144 CPX-Variante steigert die Leistung noch weiter und integriert 144 Rubin CPX-GPUs neben 144 Standard-Rubin-GPUs und 36 Vera-CPUs, um acht ExaFLOPs NVFP4-Rechenleistung - eine 7,5-fache Verbesserung gegenüber GB300 NVL72 - mit 100 TB Hochgeschwindigkeitsspeicher und 1,7 PB/s Speicherbandbreite in einem einzigen Rack zu liefern.¹⁴

Mit Rubin Ultra und der Kyber-Rack-Architektur wird sich im Jahr 2027 alles ändern. Das NVL576-System packt 576 GPU-Chips in ein einziges Rack und verbraucht 600 kW Strom - das Fünffache aktueller Systeme.¹⁵ Das Kyber-Design dreht die Compute-Blades um 90 Grad in eine vertikale Ausrichtung und packt vier Pods mit je 18 Blades in das Rack.¹⁶ Jedes Blade beherbergt acht Rubin Ultra-GPUs neben Vera-CPUs und erreicht so eine Dichte, die noch vor wenigen Jahren unmöglich schien.

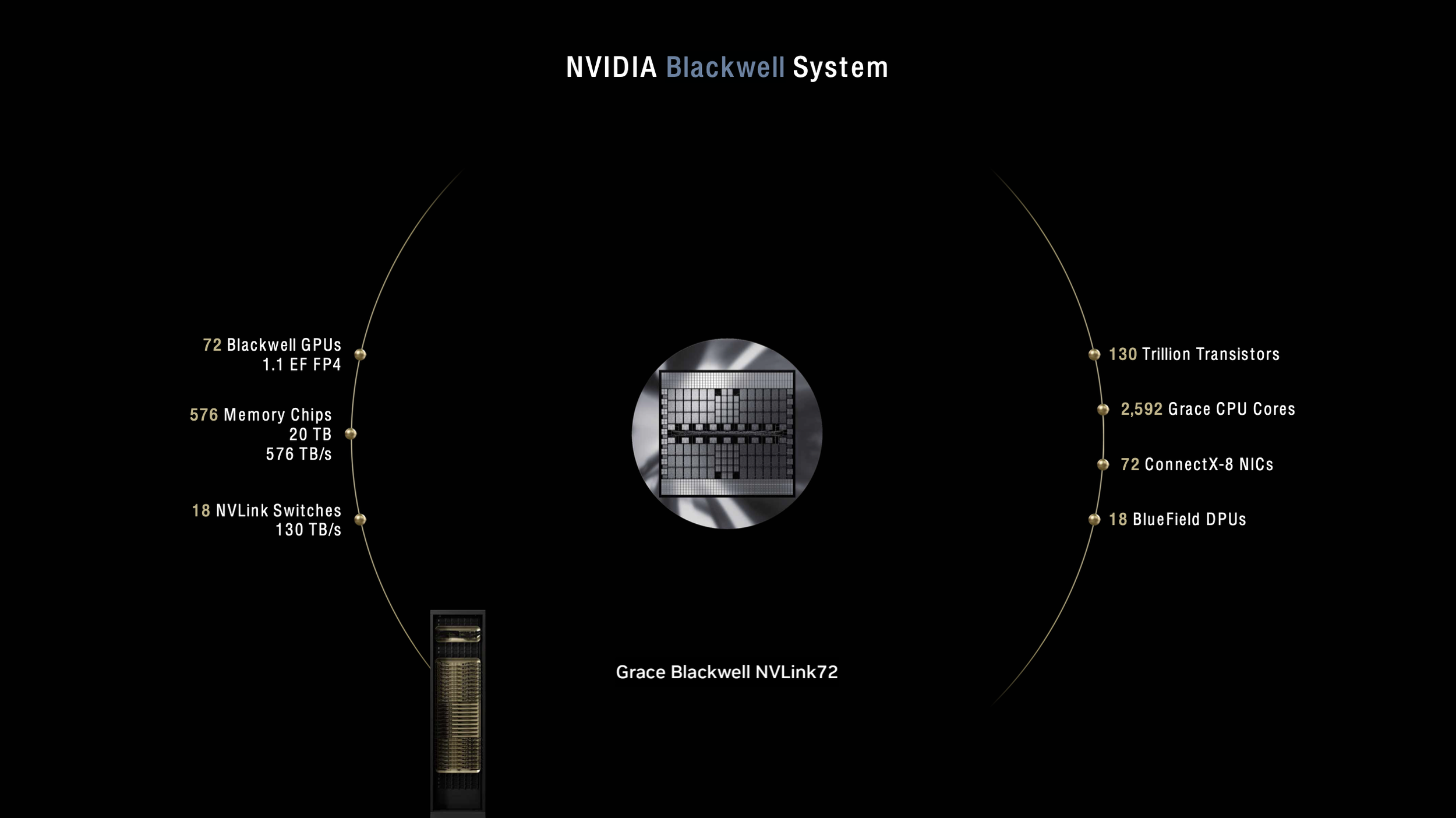

Aktuelles NVIDIA Blackwell System mit 72 GPUs und 1,1 Exaflops

Das künftige NVIDIA Rubin System skaliert auf 576 Grafikprozessoren und 15 Exaflops in einem einzigen 600-kW-Rack

Die Kühlung dieser Systeme erfordert ein komplettes Eintauchen in die Flüssigkeit ohne Lüfter - eine Abkehr von den derzeitigen Systemen, die immer noch eine gewisse Luftkühlung für Hilfskomponenten verwenden.¹⁷ CoolIT Systems und Accelsius haben bereits Kühllösungen demonstriert, die 250-kW-Racks mit einer Wassertemperatur von 40 °C am Einlass handhaben können, und damit den technologischen Weg für 600-kW-Systeme bestätigt.¹⁸ Das Kyber-Rack umfasst einen speziellen Seitenwagen für die Strom- und Kühlungsinfrastruktur, was effektiv zwei Rack-Footprints für jedes 600-kW-System erfordert.¹⁹

Die Weiterentwicklung der Stromversorgungsarchitektur ermöglicht das Rechnen im Megawattbereich.

NVIDIAs Umstellung auf eine 800-V-DC-Stromverteilung adressiert grundlegende physikalische Beschränkungen der aktuellen Infrastruktur. Die herkömmliche 54-Volt-Verteilung im Rack würde für Kyber-Scale-Systeme 64 Höheneinheiten erfordern und keinen Platz für die eigentliche Rechenleistung lassen.²⁰ Die 800-Volt-Architektur eliminiert die AC/DC-Wandlung auf Rack-Ebene, verbessert die End-to-End-Effizienz um bis zu 5 % und reduziert die Wartungskosten um bis zu 70 %.²¹

Die neue Stromversorgungsinfrastruktur unterstützt Racks mit einer Leistung von 100 kW bis über 1 MW, die denselben Backbone nutzen, und bietet die für künftige Generationen erforderliche Skalierbarkeit.²² Unternehmen, die Vera Rubin einsetzen, müssen massive elektrische Upgrades einplanen - ein einziges NVL576-Rack verbraucht so viel Strom wie 400 typische Haushalte. Rechenzentren, die den Einsatz im Jahr 2027 planen, sollten jetzt mit der Aufrüstung der Infrastruktur beginnen, einschließlich Stromanschlüssen im Versorgungsbereich und potenzieller Stromerzeugung vor Ort.

Für Infrastrukturspezialisten wie Introl eröffnet dieser Wandel ungeahnte Möglichkeiten. Die Erfahrung des Unternehmens bei der Bereitstellung von GPU-Infrastrukturen in großem Maßstab, die Verwaltung von über 100.000 GPUs weltweit und seine umfassende APAC-Präsenz positionieren Unternehmen brauchen Partner, die nicht nur die GPU-Bereitstellung verstehen, sondern auch das komplizierte Zusammenspiel von Stromversorgung, Kühlung und Vernetzung, das für 600-kW-Systeme erforderlich ist.

Leistungssteigerungen rechtfertigen Investitionen in die Infrastruktur.

Die Vera Rubin NVL144 CPX-Variante zeigt das Potenzial der Plattform mit acht exaFLOPS NVFP4-Rechenleistung, 100 TB Hochgeschwindigkeitsspeicher und 1,7 PB/s Speicherbandbreite - alles in einem einzigen Rack.²⁴ NVIDIA behauptet, dass Unternehmen eine 30- bis 50-fache Investitionsrendite erzielen können, was bei einer Investition von 100 Millionen US-Dollar einen Umsatz von 5 Milliarden US-Dollar bedeutet.²⁵

Zu den ersten Anwendern gehört das deutsche Leibniz-Rechenzentrum, das den Supercomputer Blue Lion mit Vera Rubin einsetzt, um die 30-fache Rechenleistung seines derzeitigen Systems zu erreichen.²⁶ Das Doudna-System des Lawrence Berkeley National Lab wird ebenfalls auf Vera Rubin laufen und Simulation, Daten und KI in einer einzigen Plattform für wissenschaftliches Rechnen kombinieren.²⁷

Die Spezialisierung der Rubin CPX auf die Kontextverarbeitung adressiert einen kritischen Engpass in aktuellen KI-Systemen. Unternehmen wie Cursor, Runway und Magic erforschen bereits, wie CPX Kodierassistenten und Anwendungen zur Videogenerierung beschleunigen kann, die die gleichzeitige Verarbeitung von Millionen von Token erfordern.²⁸ Die Fähigkeit, ganze Codebasen oder stundenlange Videos im aktiven Speicher zu halten, verändert die Möglichkeiten von KI-Anwendungen grundlegend.

Herausforderungen in der Infrastruktur schaffen Marktchancen.

Der Sprung zu 600-kW-Racks offenbart harte Realitäten hinsichtlich der aktuellen Rechenzentrumsleistung. Die meisten Einrichtungen haben mit 40-kW-Racks zu kämpfen; selbst modernste KI-Rechenzentren kommen selten über 120 kW hinaus. Die Umstellung erfordert nicht nur neue Kühlsysteme, sondern auch eine komplette Neugestaltung der Einrichtungen, von Betonböden, die massive Gewichtslasten tragen können, bis hin zu elektrischen Umspannwerken, die für den industriellen Betrieb ausgelegt sind.

"Es bleibt die Frage, wie viele bestehende Rechenzentren in der Lage sein werden, eine solch dichte Konfiguration zu unterstützen", stellt The Register fest und hebt hervor, dass die kundenspezifische Bauweise der Kyber-Racks bedeutet, dass die Einrichtungen eine spezielle Infrastruktur benötigen.²⁹ Entwicklungen auf der grünen Wiese in Regionen mit einem Überschuss an erneuerbarer oder nuklearer Energie - Skandinavien, Quebec und die Vereinigten Arabischen Emirate - werden wahrscheinlich zur Einführung führen.³⁰

Der Zeitplan verschafft der Branche einen gewissen Spielraum, erfordert jedoch sofortiges Handeln. Unternehmen, die eine KI-Infrastruktur für 2027 und darüber hinaus planen, müssen jetzt Entscheidungen über Standorte, Strombeschaffung und Kühlungsarchitektur treffen. Die Vorlaufzeit von drei Jahren spiegelt die Komplexität der Bereitstellung einer Infrastruktur wider, die an der Grenze des physikalisch Machbaren arbeitet.

Der Weg nach Vera Rubin

Die Roadmap von NVIDIA reicht über Vera Rubin hinaus bis zur Feynman-Architektur im Jahr 2028, die wahrscheinlich auf 1-Megawatt-Racks zusteuert.³¹ Vertiv-CEO Giordano Albertazzi ist der Meinung, dass das Erreichen einer Dichte im MW-Bereich "eine weitere Revolution bei der Flüssigkeitskühlung und einen Paradigmenwechsel auf der Energieseite" erfordert.³² Die Entwicklung scheint unvermeidlich zu sein - KI-Workloads erfordern eine exponentielle Zunahme der Rechendichte, und die Wirtschaftlichkeit begünstigt die Konzentration gegenüber der Verteilung.

Der Wechsel von schrittweisen Verbesserungen zu revolutionären Veränderungen in der GPU-Infrastruktur spiegelt den allgemeinen Wandel der KI wider. So wie große Sprachmodelle von Milliarden auf Billionen von Parametern angestiegen sind, muss auch die Infrastruktur, die sie unterstützt, ähnliche Sprünge machen. Vera Rubin steht nicht nur für schnellere Grafikprozessoren, sondern für ein grundlegendes Umdenken bei der Funktionsweise der Recheninfrastruktur.

Für Unternehmen wie Introl, die sich auf die Bereitstellung von GPU-Infrastrukturen spezialisiert haben, eröffnet Vera Rubin eine neue Generation von Möglichkeiten. Unternehmen brauchen Partner, die die Komplexität von 600-kW-Implementierungen bewältigen können, von der anfänglichen Planung über die Implementierung bis hin zur laufenden Optimierung. Die Unternehmen, die Vera Rubin erfolgreich einsetzen, werden erhebliche Wettbewerbsvorteile bei den KI-Fähigkeiten erlangen, während diejenigen, die zögern, Gefahr laufen, beim Wettlauf der Branche in Richtung Exascale-KI den Anschluss zu verlieren.

Schlussfolgerung

Die Vera Rubin-Plattform von NVIDIA zwingt die Rechenzentrumsbranche dazu, sich mit unbequemen Wahrheiten über die Grenzen der Infrastruktur auseinanderzusetzen und bietet gleichzeitig beispiellose Rechenleistungen. Die 600-kW-Racks des Jahres 2027 stellen mehr als nur einen höheren Stromverbrauch dar - sie markieren einen kompletten Wandel in der Art und Weise, wie KI-Infrastrukturen gebaut, gekühlt und betrieben werden. Unternehmen, die jetzt mit der Planung beginnen und mit erfahrenen Infrastrukturspezialisten zusammenarbeiten, die die Komplexität von Implementierungen der nächsten Generation verstehen, werden am besten positioniert sein, um die revolutionären Fähigkeiten zu nutzen, die Vera Rubin ermöglicht.

Die Ankunft der Plattform im Jahr 2026-2027 gibt der Branche Zeit, sich vorzubereiten, aber die Uhr tickt. Rechenzentren, die heute entworfen werden, müssen die Anforderungen von morgen vorwegnehmen, und Vera Rubin macht deutlich, dass die Zukunft radikale Abkehr von konventionellem Denken erfordert. Die Unternehmen, die diesen Wandel vollziehen, werden die nächste Generation von KI-Durchbrüchen vorantreiben, von Sprachmodellen mit Millionen von Wörtern bis hin zu Echtzeit-Videogenerierungssystemen, die heute noch wie Science-Fiction wirken.

Referenzen

¹ The Register. "Nvidias Vera Rubin CPU, GPUs nehmen Kurs auf 600-kW-Racks". March 19, 2025. https://www.theregister.com/2025/03/19/nvidia_charts_course_for_600kw.

² NVIDIA Newsroom. "NVIDIA stellt Rubin CPX vor: eine neue GPU-Klasse, die für Massive-Context-Inferenz entwickelt wurde." 2025. https://nvidianews.nvidia.com/news/nvidia-unveils-rubin-cpx-a-new-class-of-gpu-designed-for-massive-context-inference..

³ Ibid.

⁴ Data Center Dynamics. "GTC: Jensen Huang, Ian Buck und Charlie Boyle von Nvidia über die Zukunft der Rackdichte in Rechenzentren." March 21, 2025. https://www.datacenterdynamics.com/en/analysis/nvidia-gtc-jensen-huang-data-center-rack-density/ ..

⁵ TechPowerUp. "NVIDIA stellt Vera CPU und Rubin Ultra AI GPU vor und kündigt Feynman-Architektur an." 2025. https://www.techpowerup.com/334334/nvidia-unveils-vera-cpu-and-rubin-ultra-ai-gpu-announces-feynman-architecture..

⁶ CNBC. "Nvidia kündigt Blackwell Ultra und Vera Rubin KI-Chips an." March 18, 2025. https://www.cnbc.com/2025/03/18/nvidia-announces-blackwell-ultra-and-vera-rubin-ai-chips-.html.

⁷ Yahoo Finance. "Nvidia stellt Vera Rubin-Superchip der nächsten Generation auf der GTC 2025 vor." March 18, 2025. https://finance.yahoo.com/news/nvidia-debuts-next-generation-vera-rubin-superchip-at-gtc-2025-184305222.html.

⁸ Nächste Plattform. "Nvidia Draws GPU System Roadmap Out To 2028." June 5, 2025. https://www.nextplatform.com/2025/03/19/nvidia-draws-gpu-system-roadmap-out-to-2028/ ..

⁹ SemiAnalysis. "NVIDIA GTC 2025 - Built For Reasoning, Vera Rubin, Kyber, CPO, Dynamo Inference, Jensen Math, Feynman." August 4, 2025. https://semianalysis.com/2025/03/19/nvidia-gtc-2025-built-for-reasoning-vera-rubin-kyber-cpo-dynamo-inference-jensen-math-feynman/ ..

¹⁰ NVIDIA Newsroom. "NVIDIA stellt Rubin CPX vor: eine neue GPU-Klasse, die für Massive-Context-Inferenz entwickelt wurde."

¹¹ Ebd.

¹² Tom's Hardware. "Nvidia kündigt Rubin-GPUs für 2026 an, Rubin Ultra für 2027, Feynman ebenfalls auf der Roadmap." March 18, 2025. https://www.tomshardware.com/pc-components/gpus/nvidia-announces-rubin-gpus-in-2026-rubin-ultra-in-2027-feynam-after.

¹³ Der neue Stack. "NVIDIA stellt die Rubin- und Feynman-Architekturen der nächsten Generation vor und verschiebt die Leistungsgrenzen der KI." April 14, 2025. https://thenewstack.io/nvidia-unveils-next-gen-rubin-and-feynman-architectures-pushing-ai-power-limits/.

¹⁴ NVIDIA Newsroom. "NVIDIA stellt Rubin CPX vor: eine neue GPU-Klasse, die für Massive-Context-Inferenz entwickelt wurde."

¹⁵ Data Center Dynamics. "Nvidias Rubin Ultra NVL576-Rack wird voraussichtlich 600 kW haben und in der zweiten Hälfte des Jahres 2027 erscheinen." March 18, 2025. https://www.datacenterdynamics.com/en/news/nvidias-rubin-ultra-nvl576-rack-expected-to-be-600kw-coming-second-half-of-2027/ ..

¹⁶ Tom's Hardware. "Nvidia zeigt Rubin Ultra mit 600.000-Watt-Kyber-Racks und Infrastruktur, kommt 2027". March 19, 2025. https://www.tomshardware.com/pc-components/gpus/nvidia-shows-off-rubin-ultra-with-600-000-watt-kyber-racks-and-infrastructure-coming-in-2027 ..

¹⁷ Data Center Dynamics. "GTC: Jensen Huang, Ian Buck und Charlie Boyle von Nvidia über die Zukunft der Rackdichte in Rechenzentren".

¹⁸ Data Center Frontier. "CoolIT und Accelsius verschieben die Grenzen der Flüssigkeitskühlung in Rechenzentren inmitten steigender Rack-Dichten." 2025. https://www.datacenterfrontier.com/cooling/article/55281394/coolit-and-accelsius-push-data-center-liquid-cooling-limits-amid-soaring-rack-densities.

¹⁹ Data Center Dynamics. "GTC: Jensen Huang, Ian Buck und Charlie Boyle von Nvidia über die Zukunft der Rackdichte in Rechenzentren".

²⁰ NVIDIA Technical Blog. "NVIDIA 800 VDC Architektur wird die nächste Generation von KI-Fabriken antreiben." May 20, 2025. https://developer.nvidia.com/blog/nvidia-800-v-hvdc-architecture-will-power-the-next-generation-of-ai-factories/ ..

²¹ Ebd.

²² Ebd.

²³ Einleitung. "Erfassungsbereich". Zugriff im Jahr 2025. https://introl.com/coverage-area.

²⁴ NVIDIA Newsroom. "NVIDIA stellt Rubin CPX vor: eine neue GPU-Klasse, die für Massive-Context-Inferenz entwickelt wurde."

²⁵ Ebd.

²⁶ NVIDIA Blog. "Blue Lion Supercomputer wird auf NVIDIA Vera Rubin laufen." June 10, 2025. https://blogs.nvidia.com/blog/blue-lion-vera-rubin/ ..

²⁷ Ebd.

²⁸ NVIDIA Newsroom. "NVIDIA stellt Rubin CPX vor: eine neue GPU-Klasse, die für Massive-Context-Inferenz entwickelt wurde."

²⁹ The Register. "Nvidias Vera Rubin CPU, GPUs nehmen Kurs auf 600kW-Racks".

Global Data Center Hub. "Nvidia's 600kW Racks Are Here (Is Your Infrastructure Ready?)". March 23, 2025. https://www.globaldatacenterhub.com/p/issue-8-nvidias-600kw-racks-are-hereis.

³¹ TechPowerUp. "NVIDIA stellt Vera-CPU und Rubin Ultra AI-GPU vor und kündigt Feynman-Architektur an".

³² Data Center Dynamics. "GTC: Jensen Huang, Ian Buck und Charlie Boyle von Nvidia über die Zukunft der Rackdichte in Rechenzentren".