Introl Blog

**

Introl Blog **

Afrikas KI-Rechenzentrums-Boom: Chancen in Nigeria, Kenia und Südafrika

Afrika entwickelt sich zur nächsten großen KI-Infrastruktur-Grenze der Welt, angeführt von schnell wachsenden Märkten in Nigeria, Kenia und Südafrika. Mit Milliardenbeträgen, die in Cloud-Regionen, Unterseekabel, erneuerbare Energien und Hyperscale-Rechenzentren fließen, startet der Kontinent in eine neue Ära der digitalen Expansion. Eine junge, mobilitätsorientierte Bevölkerung und die rasche Einführung von Finanztechnologien treiben diesen Wandel voran und schaffen eine starke Nachfrage nach Rechen-, Verbindungs- und Cloud-Diensten. Für Investoren bietet Afrika ein seltenes frühes Wachstum in einem Markt, der bis 2027 ein Volumen von 5 Milliarden US-Dollar erreichen wird.

KI-Infrastruktur in Lateinamerika: Chancen für Rechenzentren in Brasilien und Mexiko

São Paulo entwickelt sich mit einer Kapazität von 100 MW zu Lateinamerikas Hauptstadt der Rechenzentren. Mexikos Nearshoring-Boom zieht ausländische Investitionen in Höhe von 50 Milliarden Dollar an. Das 10-Milliarden-Dollar-Engagement von AWS für die mexikanische Cloud-Infrastruktur signalisiert auch beispiellose Chancen auf dem lateinamerikanischen KI-Markt. Brasilien hat 215 Millionen Einwohner, die die größte digitale Wirtschaft der Region mit einem Wert von 200 Milliarden US-Dollar schaffen.

Edge-KI-Infrastruktur: Einsatz von GPUs in der Nähe von Datenquellen

Einsatz von Edge-GPUs für 95 % geringere Latenz und 82 % Bandbreiteneinsparung. Von der Jetson- bis zur T4-Auswahl, Leistungseinschränkungen und realen Implementierungen. Vollständiger Leitfaden.

Aufbau eines KI-Infrastruktur-Teams: NVIDIA Zertifizierungs-Roadmap für 2025

Der Mangel an 85.000 GPU-Ingenieuren treibt die Gehälter auf über 350.000 Dollar. NVIDIA zertifiziert jährlich nur 12.000 im Vergleich zu 97.000 benötigten Ingenieuren. Bauen Sie Ihr Team mit dieser Roadmap für 2025 auf.

KI-Revolution im Nahen Osten: Die Infrastrukturpläne der VAE und Saudi-Arabiens im Wert von über 100 Milliarden Dollar

Saudi-Arabiens 500-Milliarden-Dollar-NEOM, der KI-Minister der Vereinigten Arabischen Emirate und Katars 10-Milliarden-Dollar-Digitalfonds veranschaulichen unterschiedliche regionale Ansätze für ein KI-gestütztes Wachstum. Unterstützt durch ein Vermögen von 3 Billionen Dollar in den Golfstaaten werden die Investitionen in die KI-Infrastruktur bis 2030 100 Milliarden Dollar übersteigen. Globale Tech-Giganten wie Microsoft, Oracle und AWS stellen erhebliches Kapital zur Verfügung. Diese Analyse vergleicht die nationalen Strategien und zeigt, wie der aufstrebende KI-Markt des Nahen Ostens einzigartige nationale Modelle und grenzüberschreitende Chancen bietet.

Google TPU v6e vs GPU: 4x bessere KI-Leistung pro Dollar Leitfaden

Google TPU v6e bietet eine 4x bessere Leistung pro Dollar als GPUs für KI-Training. Erfahren Sie mehr über Einsatzstrategien, Kostenanalysen und optimale Anwendungsfälle

40-250 kW pro Rack: Lösungen für Rechenzentren mit extremer Dichte

Moderne KI erfordert 40-250 kW pro Rack, während die herkömmliche Kühlung bei 15 kW versagt. Erfahren Sie mehr über technische Lösungen für die Bereitstellung von Infrastrukturen mit extremer Dichte.

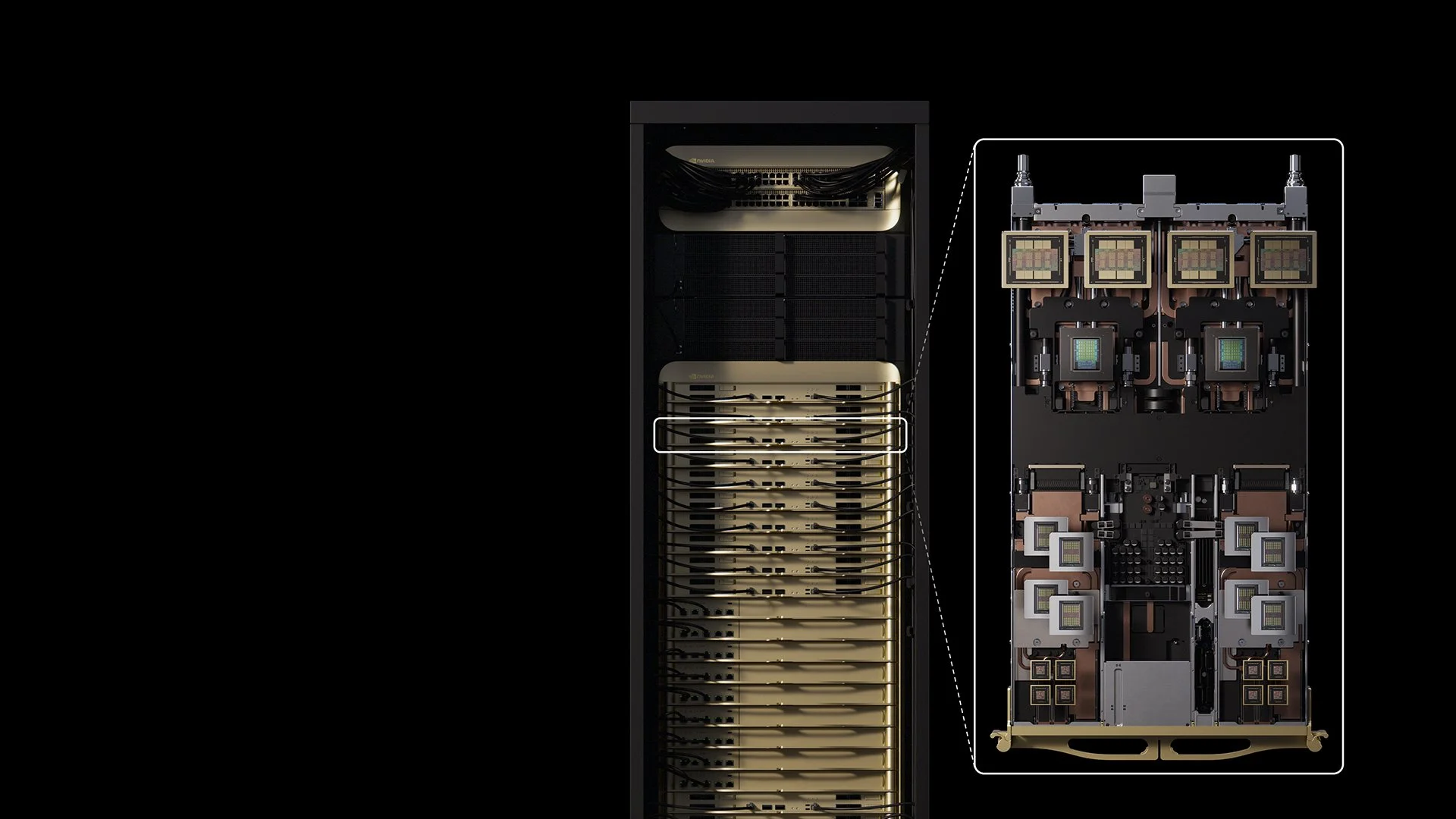

OpenAI-NVIDIA $100B Deal: 10 Gigawatt KI-Infrastruktur

OpenAI und NVIDIA kündigen eine 100-Milliarden-Dollar-Partnerschaft an, um eine 10-Gigawatt-KI-Infrastruktur aufzubauen, wobei die Vera-Rubin-Plattform ab 2026 acht Exaflops liefern soll.

VVater und Introl kündigen Partnerschaft an, um die Zukunft von KI-Rechenzentren neu zu definieren

VVater und Introl kooperieren, um KI-Rechenzentren mit nachhaltiger Wassertechnologie zu revolutionieren. 4,3 Mrd. Gallonen aufbereitet, 80 % Betriebskosteneinsparungen bei der Skalierung der GPU-Infrastruktur.

NVIDIA Vera Rubin durchbricht die GPU-Form mit 600-Kilowatt-Racks und Millionen-Token-Speicher

NVIDIA Vera Rubin treibt Rechenzentren bis 2027 auf 600-kW-Racks voran, die eine 7,5-fache Leistungssteigerung bieten und gleichzeitig eine vollständige Umgestaltung der Infrastruktur erfordern.

CoreWeave: Die KI-Infrastruktur-Revolution - Wie ein Krypto-Mining-Startup zum 23-Milliarden-Dollar-Backbone der Künstlichen Intelligenz wurde

CoreWeave hat sich vom Krypto-Mining zum 23 Milliarden Dollar schweren KI-Infrastruktur-Backbone gewandelt und dabei ein Umsatzwachstum von 737 % erzielt, während es die Grundmodelle von OpenAI vorantrieb.

Lokaler LLM-Hardware-Leitfaden 2025: Preise und Spezifikationen

Duale RTX 5090s entsprechen der H100-Leistung für 70B-Modelle zu 25 % Kosten. Vollständiger Hardware-Preisleitfaden für die lokale LLM-Bereitstellung von Consumer- bis Enterprise-GPUs.

Das Stargate von OpenAI: Ein 500-Milliarden-Dollar-Joint-Venture für die KI von morgen

Stargate von OpenAI, ein 500 Milliarden Dollar schweres Joint Venture mit SoftBank, Oracle und MGX, baut das weltweit größte KI-Infrastrukturnetzwerk auf, um die Revolution der künstlichen Intelligenz von morgen voranzutreiben.

Introl auf Platz 14 der 2025 Inc. 5000 mit 9.594% Wachstum

Introl rangiert auf Platz 14 der Inc. 5000 mit einem Wachstum von 9.594 % und ist damit der am schnellsten wachsende GPU-Infrastrukturspezialist Amerikas, der die KI-Revolution vorantreibt.

Indiens GPU-Infrastruktur-Revolution: Von 80.000 GPUs zu 100-Milliarden-Dollar-Investitionen

Indien setzt 80.000+ GPUs ein und hat bis 2027 eine Investitionspipeline von 100 Mrd. USD, was eine CAGR von 34,4 % bedeutet und den am schnellsten wachsenden KI-Infrastrukturmarkt in Asien darstellt.

NVIDIA Omniverse: Das physische KI-Betriebssystem für $50T

NVIDIA Omniverse versorgt 252+ Unternehmen mit 30-70% Effizienzsteigerung. Das 50 Billionen Dollar teure physische KI-Betriebssystem transformiert Fertigung, Robotik und autonome Fahrzeuge.

NVIDIAs FP4-Inferenz bietet 50-fache Effizienz

FP4-Inferenz liefert 25-50-fache Energieeffizienz bei 3,5-facher Speicherreduzierung. DeepSeek-R1 erreicht 250+ Token/Sek. Die Ära der $0,02/Token bricht an.

Malaysias 15 Milliarden Dollar teure KI-Revolution treibt Südostasiens digitale Zukunft voran

Malaysia sichert sich mehr als 15 Milliarden Dollar an KI-Investitionen und setzt die erste H100-GPU-Plattform der Region ein. Tech-Giganten konkurrieren, während sich Johor zum KI-Kraftzentrum Südostasiens entwickelt.

Kleine modulare Kernreaktoren (SMRs) treiben KI an: 10 Milliarden Dollar für eine nukleare Revolution, die Rechenzentren verändert

Tech-Giganten investieren mehr als 10 Milliarden Dollar in kleine modulare Reaktoren, die KI-Rechenzentren mit Strom versorgen. Erste SMR-Anlagen gehen bis 2030 ans Netz, um den Energiebedarf der KI von 945 TWh durch Kernkraft zu decken.

Singapurs 27 Milliarden Dollar schwere KI-Revolution treibt Südostasien 2025 an

Singapur verpflichtet sich zu 1,6 Mrd. $ staatlicher Finanzierung + 26 Mrd. $ Tech-Investitionen, um Südostasiens KI-Drehscheibe zu werden und 15 % des weltweiten Umsatzes von NVIDIA zu generieren.