NVIDIAs Revolution auf der Computex 2025: Verwandlung von Rechenzentren in KI-Fabriken

Jensen Huang, CEO von NVIDIA, betrat die Bühne der Computex 2025 in seiner charakteristischen Lederjacke und stellte neue Hardware und ein völlig neuartiges Computing-Paradigma vor. Der Halbleitergigant hat sich entscheidend in ein KI-Infrastrukturunternehmen verwandelt, das die Grundlagen für das schafft, was Huang "die Infrastruktur der Intelligenz" nennt - die dritte große Infrastrukturrevolution nach Elektrizität und Internet.

Diese Keynote war nicht einfach nur eine weitere Produktankündigung, sondern Jensen stellte NVIDIAs Plan für die Neugestaltung der Computerlandschaft vor. Die technischen Sprünge, strategischen Weichenstellungen und Marktstrategien, die er enthüllte, werden diese Computex wahrscheinlich zu der Computex machen, an die wir uns noch jahrelang erinnern werden. Sehen Sie sich die vollständige Computex 2025 Nvidia Keynote.

Die strategische Entwicklung von NVIDIA: Von der Grafikkarte zum Infrastrukturanbieter

Die Geschichte des Wandels von NVIDIA ist atemberaubend. Im Jahr 1993 sah Jensen eine "300-Millionen-Dollar-Chip-Chance" - einen großen Markt. Heute steht er an der Spitze eines Billionen Dollar schweren KI-Infrastruktur-Molochs. Diese Art von explosivem Wachstum passiert nicht einfach so - NVIDIA hat sich im Laufe der Zeit mehrfach grundlegend neu erfunden.

Während seiner Keynote hob Jensen die Wendepunkte hervor, die das heutige NVIDIA möglich gemacht haben:

2006: CUDA landete und stellte das parallele Rechnen auf den Kopf. Plötzlich konnten Entwickler, die den Einsatz von Grafikprozessoren für allgemeine Berechnungen nie in Betracht gezogen hatten, Anwendungen erstellen, die auf herkömmlichen CPUs unmöglich gewesen wären.

2016: Der DGX1 wurde als NVIDIAs erstes kompromissloses, auf KI fokussiertes System vorgestellt. In einer fast schon unheimlichen Vorahnung spendete Jensen das erste Gerät an OpenAI und schuf damit die rechnerische Grundlage, die schließlich zu unserer aktuellen KI-Revolution führte.

2019: Die Übernahme von Mellanox, die es NVIDIA ermöglicht, Rechenzentren als einheitliche Recheneinheiten neu zu konzipieren

Dieser Wandel gipfelt in der aktuellen Position von NVIDIA als "unverzichtbares Infrastrukturunternehmen" - ein Status, den Huang durch seine beispiellosen öffentlichen Fünf-Jahres-Roadmaps hervorhob, die eine globale Infrastrukturplanung für den Einsatz von KI ermöglichen.

Die Neudefinition von Leistungsmetriken: Die Token-Wirtschaft

NVIDIA hat einen grundlegenden Wandel bei der Messung von Rechenleistung eingeleitet. Anstelle traditioneller Metriken wie FLOPs oder Operationen pro Sekunde bezeichnete Huang die KI-Rechenzentren als Fabriken, die "Tokens" produzieren - Einheiten von Rechenintelligenz:

"Die Unternehmen fangen an, darüber zu sprechen, wie viele Token sie im letzten Quartal produziert haben und wie viele Token sie im letzten Monat produziert haben. Sehr bald werden wir darüber sprechen, wie viele Token wir pro Stunde produzieren, so wie es jede Fabrik tut."

Diese Neuausrichtung stellt eine direkte Verbindung zwischen den Investitionen in die Rechenleistung und dem Geschäftsergebnis her und bringt die KI-Infrastruktur mit den traditionellen industriellen Rahmenbedingungen in Einklang. Das Modell positioniert NVIDIA im Epizentrum eines neuen wirtschaftlichen Paradigmas, bei dem sich Recheneffizienz direkt in Geschäftsfähigkeit umsetzt.

Blackwell Architektur Upgrades: GB300-Spezifikationen und Leistungsmetriken

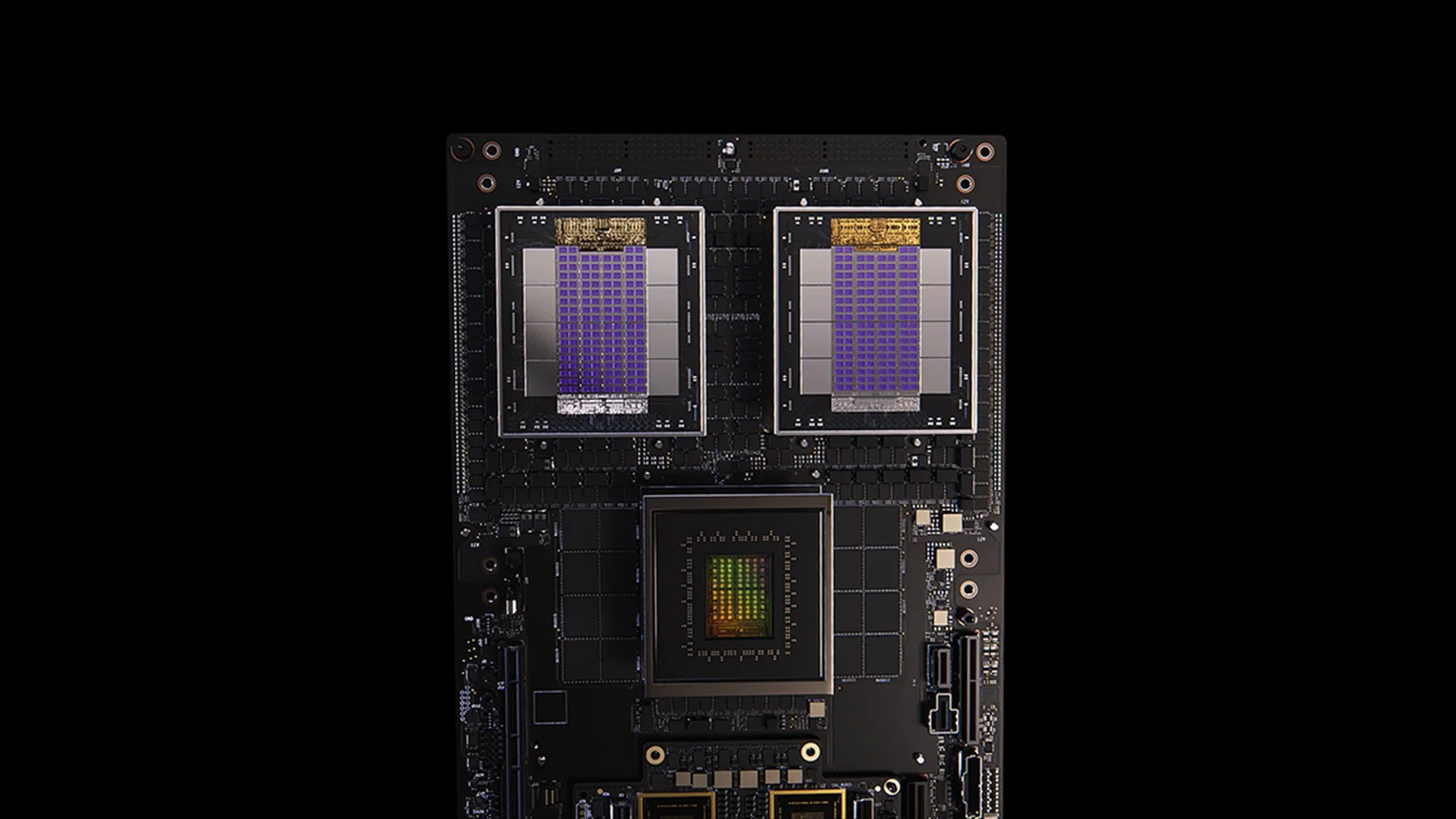

GB200-System

Das GB300-Update für die Blackwell-Architektur ist ein Beispiel für den unermüdlichen Leistungsverbesserungszyklus von NVIDIA. Der GB300 ist für Q3 2025 geplant und liefert:

1,5-fache Steigerung der Inferenzleistung gegenüber GB200

1,5-fache Steigerung der HBM-Speicherkapazität

Zweifache Verbesserung der Netzwerkbandbreite

Vollständig flüssigkeitsgekühlte Konstruktion

Abwärtskompatibel mit bestehenden Chassis und Systemen

Jeder GB300-Knoten liefert etwa 40 Petaflops und ersetzt damit den gesamten Sierra-Supercomputer (ca. 2018), der 18.000 Volta-GPUs benötigte. Dieser 4.000-fache Leistungszuwachs innerhalb von sechs Jahren übertrifft die herkömmliche Skalierung nach dem Mooreschen Gesetz bei weitem und zeigt den vielschichtigen Ansatz von NVIDIA zur Leistungssteigerung durch Architektur-, Software- und Verbindungsinnovationen.

MVLink: Neudefinition der Verbindungstechnologie

MVLink ist der bedeutendste Fortschritt in der GPU-Verbindungstechnologie seit der Einführung von NVLink. Das System ermöglicht die vollständige Disaggregation von Rechenressourcen über ein ganzes Rack hinweg und verwandelt 72 GPUs (144 GPU-Dies) in eine einzige massive Recheneinheit.

Die technischen Daten sind atemberaubend:

Einzelne MVLink-Switches: 7,2 TB/s Bandbreite

MVLink-Rückgrat: 130 TB/s All-to-All-Bandbreite

Physikalische Umsetzung: 5.000 präzise längenangepasste Koaxialkabel (insgesamt etwa 2 Meilen)

Leistungsdichte: 120 Kilowatt pro Rack (erfordert Flüssigkeitskühlung)

Huang wies darauf hin, dass der Spitzenverkehr des gesamten Internets etwa 900 Terabit pro Sekunde (112,5 TB/s) beträgt, so dass ein einziges MVLink-Spine mehr Datenverkehr bewältigen kann als das globale Internet bei Spitzenkapazität.

MVLink Fusion: Schaffung eines offenen KI-Infrastruktur-Ökosystems

MVLink Fusion könnte der innovativste Schritt sein, den NVIDIA seit Jahren in Sachen Ökosystem gemacht hat. Anstatt Partner zu zwingen, komplett auf NVIDIA-Hardware zu setzen, wird die Architektur geöffnet, damit Unternehmen semi-custom KI-Systeme bauen können, die dennoch in das NVIDIA-Universum eingebunden sind.

Der Ansatz ist erstaunlich flexibel:

Kundenspezifische ASIC-Integration: Haben Sie einen speziellen Beschleuniger? Kein Problem! Partner können MVLink Chiplets einsetzen, um ihr kundenspezifisches Silizium mit NVIDIAs Ökosystem zu verbinden. Das ist so, als würde NVIDIA sagen: "Baut, was immer ihr wollt - stellt nur sicher, dass es mit unserem Material kommunizieren kann."

Kundenspezifische CPU-Integration: Auch CPU-Anbieter sind nicht außen vor gelassen. Sie können die Chip-to-Chip-Schnittstellen von MVLink direkt implementieren und so eine direkte Verbindung zwischen ihren Prozessoren und Blackwell-GPUs (oder der kommenden Ruben-Architektur) herstellen. MVLink ist für Unternehmen, die in bestimmte CPU-Architekturen investieren, von großer Bedeutung.

Die Ankündigung der Partner umfasst die gesamte Halbleiterindustrie:

Silizium-Implementierungspartner: LCHIP, Astera Labs, Marll, MediaTek

CPU-Anbieter: Fujitsu, Qualcomm

EDA-Anbieter: Cadence, Synopsis

Mit diesem Ansatz ist NVIDIA strategisch so positioniert, dass es unabhängig vom spezifischen Hardware-Mix, den die Kunden einsetzen, Wertzuwächse erzielt, was Huangs ehrliche Aussage widerspiegelt: "Nichts macht mir mehr Freude, als wenn Sie alles von NVIDIA kaufen. Ich möchte, dass ihr das wisst. Aber es bereitet mir eine große Freude, wenn Sie etwas von NVIDIA kaufen."

KI-Bereitstellung für Unternehmen: RTX Pro Enterprise und Omniverse Server

Der RTX Pro Enterprise und der Omniverse Server sind NVIDIAs bedeutendstes Compute-Angebot für Unternehmen, das speziell für die Integration von KI-Funktionen in traditionelle IT-Umgebungen entwickelt wurde:

Vollständig x86-kompatible Architektur

Unterstützung für traditionelle Hypervisoren (VMware, Red Hat, Nanix)

Kubernetes-Integration für vertraute Workload-Orchestrierung

Blackwell RTX Pro 6000s GPUs (8 pro Server)

CX8-Netzwerkchip mit 800 Gb/s Bandbreite

1,7-facher Leistungszuwachs gegenüber Hopper H100

4x Leistung bei optimierten Modellen wie Deepseek R1

Das System setzt neue Maßstäbe für die Leistung von KI-Inferenzen, die auf zwei Achsen gemessen werden: Durchsatz (Token pro Sekunde) und Reaktionsfähigkeit (Token pro Sekunde pro Benutzer) - entscheidende Messgrößen für das, was Huang als Ära der "Skalierung der Inferenzzeit" oder "denkende KI" bezeichnet.

AI-Datenplattform: Neue Ideen für die Speicherung unstrukturierter Daten

Die KI-Datenplattform von NVIDIA bietet einen grundlegend anderen Ansatz für Unternehmensspeicher:

"Menschen fragen strukturierte Datenbanken wie SQL ab... Aber KI will unstrukturierte Daten abfragen. Sie wollen semantische Daten. Sie wollen Bedeutung. Und deshalb müssen wir eine neue Art von Speicherplattform schaffen."

Die wichtigsten Komponenten sind:

NVIDIA AIQ (oder IQ): Eine semantische Abfrageschicht

GPU-beschleunigte Speicherknoten, die herkömmliche CPU-zentrierte Architekturen ersetzen

Nachtrainierte KI-Modelle mit transparenter Herkunft der Trainingsdaten

15-mal schnellere Abfragen mit 50 % besseren Ergebnissen im Vergleich zu bestehenden Lösungen

Zu den Partnern aus der Speicherbranche, die diese Architektur implementieren, gehören Dell, Hitachi, IBM, NetApp und Vast, wodurch ein umfassendes KI-Datenmanagement-Ökosystem für Unternehmen entsteht.

KI-Betrieb und Robotik: Software-Frameworks für das intelligente Unternehmen

In der Keynote wurden zwei wichtige Software-Frameworks vorgestellt:

KI-Betrieb (AIOps): Ein umfassender Stack für die Verwaltung von KI-Agenten im Unternehmenskontext, einschließlich Datenkuratierung, Modellfeinabstimmung, Bewertung, Leitplanken und Sicherheit. Zu den Partnern gehören Crowdstrike, Data IQ, Data Robots, Elastic, Newonix, Red Hat und Trend Micro.

Isaac Groot Platform N1.5: Ein offenes Ökosystem für die Entwicklung von Robotern, einschließlich:

Newton Physik-Engine (entwickelt mit Google DeepMind und Disney Research)

Jetson Thor Robotik-Prozessor

NVIDIA Isaac-Betriebssystem

Groot Dreams Blaupause für die Erzeugung synthetischer Flugbahndaten

Die Robotik-Initiative steht vor einer entscheidenden Herausforderung: "Für die Robotik braucht man KI. Aber um die KI zu lehren, braucht man KI." Dieses rekursive Optimierungsmuster nutzt die generative KI, um begrenzte menschliche Demonstrationsdaten zu umfassenden Robotik-Trainingseinheiten zu erweitern.

Taiwans strategische Position in der KI-Fertigungsrevolution

Ein wesentlicher Teil der Keynote betonte die zentrale Rolle Taiwans bei der Produktion und Implementierung von KI-Technologien:

Taiwanesische Fertigungsunternehmen (TSMC, Foxconn, Wistron, Pegatron, Delta Electronics, Quanta, Wiiwin, Gigabyte) setzen NVIDIA Omniverse für die Implementierung des digitalen Zwillings ein.

TSMC nutzt KI-gestützte Tools auf CUDA-Basis zur Optimierung von Fab-Layouts und Rohrleitungssystemen

Fertigungspartner nutzen digitale Zwillinge für die virtuelle Planung und vorausschauende Wartung sowie als "Roboter-Fitnessstudios" für das Training von Robotersystemen.

Foxconn, TSMC, die taiwanesische Regierung und NVIDIA bauen Taiwans ersten groß angelegten KI-Supercomputer.

Huang bekräftigte das Engagement von NVIDIA in der Region mit der Ankündigung der Pläne für NVIDIA Constellation", einer neuen Hauptniederlassung in Taipeh.

Technische Analyse: Was das für die KI-Strategie von Unternehmen bedeutet

Diese Ankündigungen stellen eine umfassende Neugestaltung der Unternehmensinformatik dar, die mehrere strategische Auswirkungen hat:

Anforderungen an die Rechenleistung: Die Leistungsanforderungen von "schlussfolgernder KI" und agentenbasierten Systemen an die Inferenzzeit werden zu deutlich höheren Rechenanforderungen führen als die anfänglichen großen Sprachmodelle, was eine Architekturplanung für massive Scale-up- und Scale-out-Fähigkeiten erfordert.

Disaggregation von Unternehmens-KI: Das MVLink Fusion-Ökosystem ermöglicht eine noch nie dagewesene Flexibilität beim Aufbau heterogener KI-Systeme, was die Einführung spezialisierter KI-Beschleuniger beschleunigen kann, während NVIDIAs Position im Ökosystem durch die Interconnect-Technologie erhalten bleibt.

Wechsel von Rechenzentren zu KI-Fabriken: Wir müssen die Art und Weise, wie wir den Wert unserer Infrastrukturinvestitionen messen, völlig neu überdenken. Vorbei sind die Zeiten, in denen die reine Rechen- oder Speicherkapazität die ganze Geschichte erzählt hat. Jetzt geht es nur noch um die Token-Produktion: Wie viele Einheiten an KI-Output können Ihre Systeme pro Sekunde, pro Watt und pro Dollar erzeugen? Jensen hat nicht gescherzt, als er sagte, dass Unternehmen bald über ihre Token-Produktion Bericht erstatten werden, wie z. B. über Fertigungskennzahlen. Die Umstellung auf KI-Fabriken wird die Wirtschaftlichkeit der Bereitstellung und Rechtfertigung von KI-Infrastrukturausgaben grundlegend verändern.

Integration digitaler Zwillinge: Die Tatsache, dass jeder große taiwanesische Hersteller digitale Zwillinge von Omniverse baut, sagt uns alles, was wir wissen müssen - das ist nicht mehr nur eine coole Tech-Demo. Digitale Zwillinge sind zu einer unverzichtbaren Infrastruktur für Unternehmen geworden, die es mit der Optimierung ernst meinen. Besonders faszinierend ist, wie dadurch eine Rückkopplungsschleife entsteht: Unternehmen bauen digitale Zwillinge, um physische Prozesse zu optimieren, und nutzen dann dieselben Umgebungen, um KI und Robotik zu trainieren und die physische Welt weiter zu verbessern. Es ist ein kontinuierlicher Verbesserungszyklus, der sich immer weiter beschleunigt.

Robotergestützte Personalplanung: Die Konvergenz von agentenbasierter KI und physischer Robotik legt nahe, dass Unternehmen integrierte digitale und physische Automatisierungsstrategien entwickeln sollten, was erhebliche Auswirkungen auf die Personalplanung und das Gebäudedesign hat.

Software-definierte Infrastruktur: Trotz der Hardware-Ankündigungen unterstreicht NVIDIAs anhaltende Betonung von Bibliotheken und Software-Frameworks, dass der Wettbewerbsvorteil in der KI durch Software-Optimierung ebenso wie durch reine Hardware-Fähigkeiten entstehen wird.

Den Übergang zur KI-Fabrik meistern

Die Umwandlung herkömmlicher Rechenzentren in KI-Fabriken erfordert spezielles Fachwissen, das die Bereiche Hardware-Bereitstellung, Software-Optimierung und Architekturdesign umfasst. Bei Introl haben wir diese fortschrittlichen GPU-Infrastruktur-Lösungen für Unternehmen, die sich für KI-First Computing interessieren. Die umfassende Erfahrung unseres Teams mit dem NVIDIA-Ökosystem - von komplexen MVLink-Implementierungen bis hin zu Omniverse Digital Twin-Implementierungen - hilft Unternehmen, diesen Paradigmenwechsel ohne die steile Lernkurve zu bewältigen, die normalerweise mit modernster Infrastruktur verbunden ist. Ganz gleich, ob Sie Ihre KI-Kapazitäten ausbauen oder Ihre erste KI-Fabrik einrichten möchten, die Zusammenarbeit mit Spezialisten kann Ihre Time-to-Value in dieser sich schnell entwickelnden Landschaft drastisch beschleunigen. Sind Sie bereit, es zu **erledigen? Vereinbaren Sie noch heute einen Termin.

Schlussfolgerung: Die dritte Ära des Computing ist angebrochen

Auf der Computex hat NVIDIA nicht nur schnellere Chips vorgestellt. Was Jensen vorstellte, sprengte die üblichen "20 % besser als letztes Jahr"-Ankündigungen, an die wir uns gewöhnt haben. Er hat den Zweck von Computern grundlegend neu definiert. Wir haben Jahrzehnte damit verbracht, Maschinen zu bauen, die Zahlen verarbeiten und Daten bewegen. Jetzt baut NVIDIA Systeme, die in erster Linie Intelligenz produzieren. Das ist, als würde man einen Aktenschrank mit einem Gehirn vergleichen. Sicher, beide speichern Informationen, aber das eine sitzt nur da, während das andere neue Ideen entwickelt. Diese Verschiebung mag sich wie Semantik anhören, bis man erkennt, dass sie die Art und Weise verändert, wie wir Computersysteme entwickeln, einsetzen und messen.

"Zum ersten Mal in unserer gemeinsamen Zeit schaffen wir nicht nur die nächste Generation der IT, sondern wir haben das auch schon mehrmals gemacht, vom PC über das Internet zur Cloud und zur mobilen Cloud. Wir haben das schon mehrmals gemacht. Aber dieses Mal erschaffen wir nicht nur die nächste Generation der IT, sondern eine ganz neue Branche."

Dieser Übergang stellt nach der Personal-Computing-Revolution und der Internet-/Cloud-Ära den dritten großen Paradigmenwechsel in der Datenverarbeitung dar. Unternehmen, die diese KI-Infrastrukturfunktionen integrieren, werden wahrscheinlich branchenübergreifend unüberwindbare Wettbewerbsvorteile erzielen.

Die Fabriken der Computerintelligenz sind heute im Aufbau begriffen. Die Frage ist nicht mehr, ob KI die Wirtschaft verändern wird - die Frage ist, ob Ihr Unternehmen die Infrastruktur aufbaut, um in einer Welt wettbewerbsfähig zu bleiben, in der Computerintelligenz für den Geschäftsbetrieb so grundlegend wird wie die Elektrizität.

Referenzen und zusätzliche Ressourcen

Offizielle NVIDIA Blackwell Architektur Übersicht: https://www.nvidia.com/en-us/data-center/technologies/blackwell-architecture/

NVIDIA MVLink Technische Dokumentation: https://developer.nvidia.com/mvlink

NVIDIA Omniverse Plattform: https://www.nvidia.com/en-us/omniverse/

Isaac Robotics Plattform: https://developer.nvidia.com/isaac-ros

NVIDIA AI Unternehmen: https://www.nvidia.com/en-us/data-center/products/ai-enterprise/

NVIDIA Computex 2025 Offizielle Pressematerialien: https://nvidianews.nvidia.com/news/computex-2025

Übersicht der NVIDIA CUDA-X-Bibliotheken: https://developer.nvidia.com/gpu-accelerated-libraries

NVIDIA DGX Systeme: https://www.nvidia.com/en-us/data-center/dgx-systems/